Superforecasting the end of the world. What are the chances of an AI apocalypse?

The Economist [2023], "Superforecasting the end of the world. What are the chances of an AI apocalypse?", The Economist, London, 15 de julio, https://www.economist.com/science-and-technology/2023/07/10/what-are-the...

Un ejemplo puntual para abordar el tema de riesgos existenciales (aquellos que suponen una amenaza para la humanidad como especie, más que para los individuos) es la amenaza que surgió luego de la creación de la bomba atómica (dato crucial 1). Estos riesgos abarcan un espectro de posibilidades que vaticinan escenarios catastróficos naturales o inducidos que, en última instancia, pueden suponer la extinción de la humanidad, tales como guerras nucleares, pandemias, o bien, la inteligencia artificial (IA). La presente nota aborda la tangibilidad de una extinción ocasionada por este tipo de tecnología (dato crucial 2).

En un documento publicado el de 10 de julio de 2023 elaborado por expertos como Ezra Karger, economista de la Reserva federal de Chicago, y Philip Tetlock, politólogo de la Universidad de Pensilvania, se preguntó sobre los riesgos existenciales a dos tipos de expertos: aquellos que dominan materias específicas (guerra nuclear, armas biológicas, IA y extinción) y los superpronosticadores (caracterizados por obtener predicciones bastante acertadas en diversos temas). Específicamente, la muestra incluye a 89 superpronosticadores, 65 expertos en IA y 15 en el riesgo de extinción general.

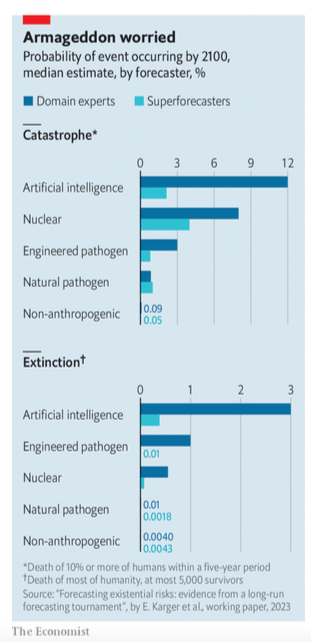

Se manejaron dos escenarios, riesgo de catástrofe y riesgo de extinción, con sucesos que van desde guerras nucleares y enfermedades hasta una IA descontrolada. Por catástrofe se entiende al suceso que acabe con 10% de la población mundial, y por extinción, al acontecimiento que aniquile a toda la población o que al menos deje con vida a cerca de 5 mil personas (dato crucial 3).

Iremos todos juntos cuando vayamos

Los resultados indican que los expertos en riesgos existenciales son más pesimistas sobre cualquier evento que represente catástrofe o extinción, sin embargo, ambos grupos coinciden en que la IA es un riesgo y catástrofe latente (dato crucial 4). Esto es así porque se considera que la IA actúa como un catalizador sobre otros eventos potenciándolos, tal es el caso del desarrollo de armas nucleares o biológicas. Ciertamente, para los superpronosticadores aún existe un hueco respecto de tales predicciones ya que las aplicaciones modernas de la IA surgieron en 2010, por lo que no se cuentan con datos históricos suficientes; así que determinar el nivel de riesgo es incierto, pero no inútil porque los conocimientos y saberes de ambos grupos se coadyuvan.

Aunado a esto, la nota sugiere que también debe de considerarse el aspecto social, ya que la posibilidad de riesgo o catástrofe depende de cómo reaccione la sociedad, recordando que los temores fundamentados sobre los efectos de la energía nuclear conllevaron a que se hiciera el esfuerzo por reducir el riesgo de una guerra nuclear por parte de entidades gubernamentales.

Tomar esto en cuenta, además sirvió para que los encuestados definieran sus predicciones sobre la gobernanza de la IA. En tal sentido, los superpronosticadores consideran que anticiparse a los efectos de dicha tecnología conllevará a un fuerte escrutinio y regulación, mientras que los expertos creen que los beneficios económicos y geopolíticos tendrán más peso que las preocupaciones por la seguridad.

Leer las runas

También se pidio a los encuestados que respondieran pruebas de indicadores de alerta temprana (medidas que sugieren si el mundo se dirige hacia un infortunio) para predecir qué eventos deben de recibir mayor atención (por ejemplo, la potencia informática que adquiere la IA progresivamente o el destino final de los tratados de control de armas nucleares). The Economist finaliza la nota puntualizando que tal encuesta pretende actualizarse para hacer las predicciones más precisas porque en este primer ejercicio los encuestados no quisieron ser más minuciosos en sus predicciones pese a que se les ofrecieron diferentes tipos de incentivos.

1) En 1945, en vísperas de las pruebas sobre la primera bomba nuclear en Nuevo México, Estados Unidos, el físico Enrico Fermi cuestionó a sus colegas sobre el riesgo de que el calor generado por la explosión ocasionara una conflagración nuclear (un impacto nuclear masivo y con efectos en el largo plazo sobre la sociedad y el medio ambiente) en la atmósfera: en caso afirmativo, ¿la explosión destruiría solo Nuevo México o también el resto del mundo? A este respecto, el físico Hans Bethe realizó una prueba similar, obteniendo que tal infierno era altamente imposible.

2) En mayo de 2023, actores sociales firmaron una carta abierta en la que se mencionaba que mitigar el riesgo de extinción por la inteligencia artificial (IA) debería ser prioridad mundial junto a otros riesgos de gran escala como las pandemias o las guerras nucleares.

3) Se calcula que la Segunda Guerra Mundial mató a cerca de 3% de la población mundial (2 mil millones para ese entonces).

4) La gráfica 1 indica la probabilidad de que un evento –catástrofe o extinción– ocurra para 2100 en los rubros inteligencia artificial (IA), ejercicios nucleares, patógenos obtenidos artificialmente o que existan en el ambiente. De este modo, la conclusión general indica que los expertos en riesgos existenciales son más pesimistas que los superpronosticadores en cualquiera de los rubros; 20% de probabilidad de catástrofe hacia 2100 y 6% hacia extinción para el mismo año, frente a 9% y 1%, respectivamente. En cuanto a los riesgos sobre la IA, el superpronosticador promedio considera un riesgo de 2.1% de catástrofe y 0.38% respecto a extinción hacia 2100.